Meer leads met minder bezoekers? Het kan!

Veel bedrijven en marketeers richten zich voornamelijk op het genereren van meer traffic naar hun website, bijvoorbeeld door middel van SEO, SEA of social media. Op zich is dat logisch, want meer bezoekers betekent vaak ook meer leads.

Er is natuurlijk niets mis met meer bezoekers, maar het binnenhalen van meer bezoekers kost vaak veel tijd en het resultaat is niet altijd goed meetbaar.

Met A/B-testing kun je ervoor zorgen dat je meer leads genereert (of meer verkoopt) met hetzelfde aantal (of minder) bezoekers.

Waarom A/B-testen?

Je klant (of manager) heeft vaak allerlei ideeën over wat er allemaal op een website of webpagina moet staan. Vaak worden dit soort beslissingen genomen op basis van gevoel of andere websites die ze mooi vinden. Dat is zonde, want je kunt veel beter achterhalen wat werkt door dit te testen.

Conversiepercentage

Het percentage van je bezoekers dat iets koopt of contact met je opneemt, heet het conversiepercentage (of conversieratio). Er zijn verschillende factoren die invloed hebben op je conversiepercentage, zoals:

- De indeling van je website.

- Hoe relevant jouw product/dienst is voor je bezoekers.

Dat laatste heeft vooral te maken met de kwaliteit van jouw bezoekers. Hier heb je niet altijd invloed op, al kun je natuurlijk advertenties proberen zo goed mogelijk te targeten op jouw doelgroep en proberen je website te optimaliseren voor de keywords waar jouw doelgroep op zoekt.

Rekenvoorbeelden

Je hebt een webshop met 1.000 bezoekers per dag en een conversieratio van 1%. Dit levert je gemiddeld dus 10 sales per dag op. Je concurrent rankt minder goed in Google en heeft “slechts” 500 bezoekers per dag, maar wel een conversiepercentage van 3%. Dit levert hem dus 15 sales per dag op.

De concurrent verkoopt dus meer, terwijl hij veel minder bezoekers op z’n website heeft!

Dit betekent natuurlijk niet dat je helemaal moet stoppen met bezoekers naar je site halen. Wel raad ik aan om deze activiteiten op een slimme manier te combineren met het optimaliseren van je conversie. En dat doe je door continu te testen wat werkt.

Een ander voorbeeld:

Je geeft €100 uit aan een Facebook-advertentie. Deze levert bijvoorbeeld 300 bezoekers op. Als je conversiepercentage op 2 procent ligt, dan is die €100 veel beter besteed dan wanneer dit 1 procent is.

De uitdaging: je klant (of baas) overtuigen

De uitdaging is vaak – ik spreek uit ervaring – om je klant of baas te overtuigen van het nut van dit soort tests. Vaak is een website of pagina namelijk gebouwd op basis van hun wensen en ideeën, en zijn ze zelf dus erg tevreden met hoe een pagina er uit ziet.

Om zo iemand tóch te overtuigen dat er getest moet worden, kun je die persoon het beste voorbeelden laten zien van (door anderen) behaalde resultaten. Dus..

Een succesverhaal

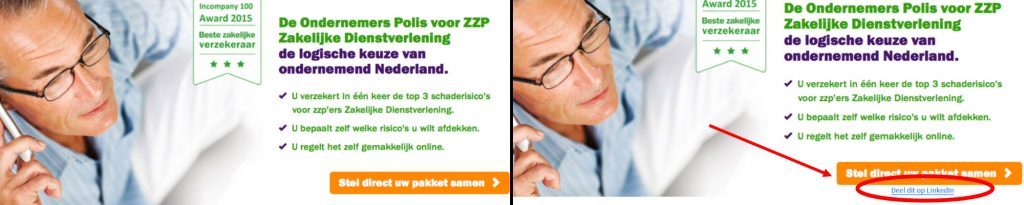

In de onderstaande afbeelding zie je een test die Achmea deed met twee variaties. Links zie je de originele pagina, en rechts de geteste variant.

Onder de belangrijke call to action-knop, plaatste Achmea een link om de pagina op LinkedIn te delen. Het was helemaal niet de bedoeling van deze pagina dat deze op LinkedIn zou worden gedeeld, dus dat iemand dit verzint is eigenlijk al bizar genoeg.

Het resultaat:

De tweede variatie (met link onder de knop) leverde maar liefst 244,7% méér clicks op. En daarmee bedoel ik dus clicks op de oranje knop. Je zou verwachten dat zo’n link onder de knop alleen maar zou afleiden. Daarom is dit ook zo’n sterk voorbeeld: je weet iets pas zeker als je het getest hebt!

Met een hele kleine aanpassing aan je pagina, kan je conversie dus al met 244 procent stijgen. Nou zijn dit soort stijgingen natuurlijk uitzonderlijk, maar een stijging van een paar procent kan ook al veel opleveren. Dit is ook de reden dat grote webshops voortdurend testen: een kleine schommeling van hun conversiepercentage kan voor zo’n webshop miljoenen euro’s verschil maken.

Nog steeds niet overtuigd? Bekijk dan ook eens deze voorbeelden.

Wat is het doel van je website?

Voordat je begint met testen is het belangrijk om ervoor te zorgen dat conversies op je website goed gemeten worden. Stel jezelf daarom de vraag: wat is het doel van mijn website? Een voorbeeld van een doel is het genereren van leads door middel van een whitepaper of contactformulier.

Zodra je hebt bepaald wat het doel is, stel je dit in Google Analytics (hoe je dat doet, lees je hier). Bij het downloaden van een whitepaper of het invullen van je contactformulier kun je het doel bijvoorbeeld instellen op de “Bedankt”-pagina.

Controleer nu of het ingestelde doel werkt, door bijvoorbeeld zelf het contactformulier in te vullen. In Google Analytics kijk je onder Real Time > Conversies of er inderdaad een conversie wordt gemeten.

Nu je een doel hebt ingesteld en hebt getest of deze goed wordt gemeten in Google Analytics, kun je een eerste A/B test gaan opzetten.

Een testdoel bepalen en een hypothese formuleren

Voordat je een test gaat uitvoeren, dien je een testdoel te bepalen én een hypothese te formuleren. Een testdoel is bijvoorbeeld het aantal clicks op een belangrijke knop, zoals bij het hierboven benoemde voorbeeld van Achmea.

Zo zou je een test kunnen doen of de knop beter werkt (dus: er vaker op geklikt wordt) als deze rood is in plaats van blauw. Je zou de hypothese dan als volgt kunnen formuleren: “Een rode knop is opvallender dan de blauwe knop, dus op de rode knop zal meer geklikt worden”. Dit is een aanname, en die hoeft dus niet te kloppen! Om er achter te komen of jouw aanname klopt ga je immers testen.

Tools voor A/B-testing

Er zijn veel tools waarmee je kunt A/B-testen. Zelf gebruik ik meestal Google Optimize. Deze tool is gratis, en om te kunnen testen hoef je alleen maar één regel code aan je (Analytics) tracking code toe te voegen. Daarnaast heeft Optimize een visuele editor, waarin je (zonder technische kennis) aanpassingen kunt doen op je website. Natuurlijk kun je met Google Optimize ook HTML- en CSS-aanpassingen doen.

Er zijn veel tools waarmee je kunt A/B-testen. Zelf gebruik ik meestal Google Optimize. Deze tool is gratis, en om te kunnen testen hoef je alleen maar één regel code aan je (Analytics) tracking code toe te voegen. Daarnaast heeft Optimize een visuele editor, waarin je (zonder technische kennis) aanpassingen kunt doen op je website. Natuurlijk kun je met Google Optimize ook HTML- en CSS-aanpassingen doen.

Hoe je een test maakt met Google Optimize, legt Google je hier uit. Het is belangrijk dat je éérst in Google Analytics een doel hebt ingesteld. Als je geen doel hebt, dan kun je ook niet testen hoe je website het doet.

Varianten maken

Om een goede test te doen, moet je eerst één of meerdere “varianten” bedenken. Hoe je website er nu uitziet is meestal Variant A, ook wel de baseline genoemd. Om te gaan testen, moet je dus minimaal een tweede variant hebben: Variant B.

Maak per test steeds één kleine aanpassing. Verander bijvoorbeeld de kleur van een knop of zet producten in je webshop in een andere volgorde. Als je meteen tien aanpassingen doet, dan weet je aan het einde van je test niet welke aanpassing het verschil heeft gemaakt.

Je kunt zo veel varianten bedenken als je wilt, maar ik raad je aan om het bij maximaal twee of drie varianten te houden (dus: Variant A, B en C). Als je er meer aanmaakt, betekent dit namelijk dat je je experiment langer moet laten lopen om een betrouwbaar resultaat te krijgen.

Voorwaarden voor je experiment

In tools als Google Optimize kun je allerlei voorwaarden instellen voor je experiment. Dit kun je doen op basis van data die ook beschikbaar is in Google Analytics.

Zo kun je er bijvoorbeeld voor kiezen om:

- je experiment alléén te laten zien aan “organische” bezoekers (die uit Google komen);

- mobiele bezoekers uit te sluiten van je experiment;

- of jouw experiment alléén te laten zien aan bezoekers uit Amsterdam.

Daarnaast kun je aangeven hoe veel procent van je bezoekers je wilt laten “meedoen” aan een experiment en kun je per variant aangeven hoe veel procent van de bezoekers die variant te zien moet krijgen. Als er bijvoorbeeld een variant tussen zit waarvan je verwacht dat de conversie heel laag is, dan kun je ervoor kiezen om deze aan 10 procent van je bezoekers te laten zien, zodat de invloed op je totale conversiepercentage niet te groot is. Het duurt dan natuurlijk wel langer voordat je voor die variant een betrouwbaar resultaat hebt.

Data verzamelen

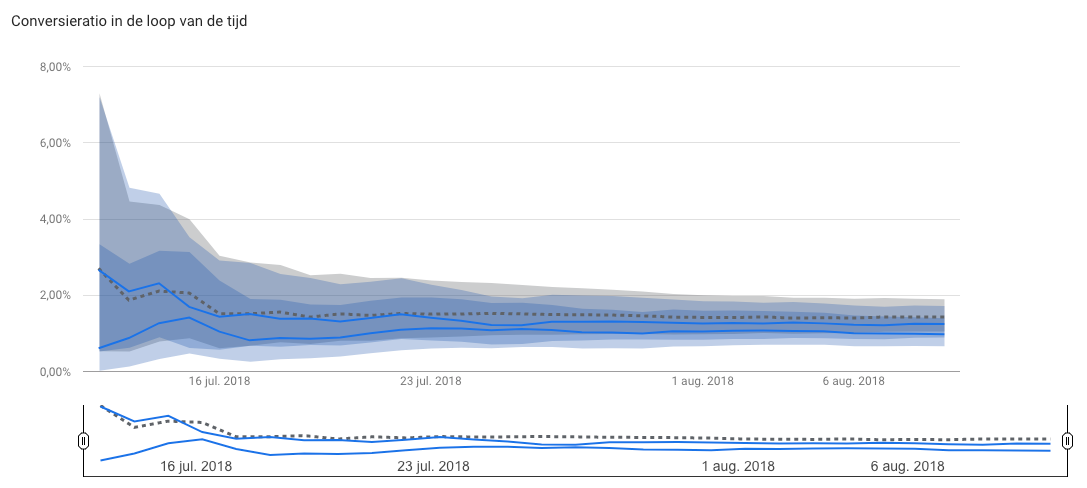

Zodra je je experiment gestart hebt, krijg je in Google Optimize en Google Analytics direct data te zien. Deze data is vaak misleidend, want de eerste paar dagen van je experiment lijkt het vaak alsof het verschil tussen de varianten heel erg groot is:

De truc is om nu niet direct conclusies te trekken. Dit verschil wordt meestal veroorzaakt doordat er een wijziging op je website heeft plaatsgevonden, en terugkerende bezoekers hier aan moeten wennen.

Zoals je in de afbeelding hierboven kunt zien neemt dit verschil (na verloop van tijd) vanzelf af. Wacht dus rustig af om een betrouwbaar resultaat te krijgen. Tools zoals Google Optimize zullen je vertellen als je genoeg data hebt verzameld.

Winnaar kiezen

Zodra je genoeg data hebt verzameld, kun je een conclusie gaan trekken. Je weet nu welke variant de “winnaar” is. Een logische volgende stap is om de winnende variant nu als nieuwe “baseline” op je website te implementeren. Heb je bijvoorbeeld getest of een rode knop beter werkt dan een blauwe knop en heeft de blauwe knop gewonnen? Vervang dan je rode knop met de blauwe knop.

Dit betekent niet dat je nu klaar bent! Je bent namelijk nooit klaar met A/B-testen. Om je conversie te (blijven) optimaliseren, begin je na iedere test weer opnieuw met een nieuwe test.

Conclusie

Het is zonde om niet te testen! Als je veel tijd, geld en moeite die steekt in het binnenhalen van (meer) bezoekers, dan wil je daar natuurlijk ook zo veel mogelijk resultaat uit halen. Dit kun je doen door continu te testen wat wel en niet werkt. Kleine aanpassingen kunnen een groot verschil maken. Stop dus met leads (of geld) laten liggen: ga direct aan de slag met testen.